|

1.4 Information und Kommunikation |

|

1.4.1 Information: Begriffsbestimmung,

Erläuterungen |

Kyb 1411 [2/7] |

|

|

b) Informationstheorie: Information als beseitigte

Unbestimmtheit |

Die informationstheoretische Ableitung und Bestimmung des

Informationsbegriffs geht vom Problem der Unbestimmtheit,

Ungewissheit aus.

Dieses Vorgehen lässt sich wie

folgt anschaulichen:

Frage 1:

Würden Sie sich mit einem Einsatz von - sagen wir - 5,00

EUR an einem Spiel "1 aus 1" beteiligen?

Antwort: Sicher nicht! Und warum

nicht?

Nun, wohl deshalb nicht, weil über den

Ausgang des Spiels keine Ungewissheit

vorliegt! Die Mitteilung "Es wurde die '1' gezogen!"

kann nicht als "Information" angesehen werden, denn dieses

Ergebnis stand schon vor der Ziehung fest.

Wir vermerken:

Wenn zu einer Situation keine

Unbestimmtheit, Ungewissheit vorliegt, dann hat eine

Mitteilung, dass dem so ist, keinen

Informationsgehalt. Der "Wert" einer solchen Information

ist gleich Null! (Dies trifft - leider - für viele

"Nachrichten" zu, die täglich in die Welt gesetzt werden).

Frage 2:

In welchem Fall liegt

eine erste (und kleinste) Unbestimmtheit vor?

Antwort: Nun offenbar dann, wenn eine

Situation zwei mögliche Ausgänge hat und jeder

der beiden Ausgänge mit gleicher Wahrscheinlichkeit

eintreten kann!

Ein Beispiel hierfür ist das "Münzwerfen",

bei dem die Ausgänge "Zahl" oder "Wappen" vor dem Wurf

gleich wahrscheinlich eintreten können.

Da es zwei

Ausgänge gibt, beträgt die Wahrscheinlichkeit jedes

einzelnen Ausganges "1/2" ("fifty-fifty).

Die

Mitteilung, dass "Zahl" (oder "Wappen") oben liegt, hat

einen Wert, denn sie hebt die vorher bestehende

Ungewissheit auf!

Die Informationstheorie hat

gezeigt, dass sich Auswahlvorgänge der skizzierten Art auf

eine Folge von "Zweier-Schritten" - im Sinne des Treffens

von Entscheidungen mit den Ausgängen "NEIN" oder "JA" -

zurückführen lassen.

Dabei wird dann diejenige

Information, die die Unbestimmtheit in einer Situation mit

zwei Ausgängen aufhebt, als Maßeinheit genutzt wird.

"Zweier-Schritt" heißt im Englischen "Binary digit"

und so entstand die Bezeichnung "Bit" als

Maßeinheit der sog. metrischen Information im

Sinne der kybernetischen Informationstheorie.

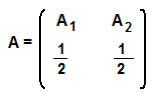

Symbolisch kann die Unbestimmtheit in Bezug auf eine

Situation A mit zwei -

gleichwahrscheinlichen - mögliche Ausgänge A1

und A2 wie folgt dargestellt

werden:

Hierbei stellt der Wert "1/2" die Wahrscheinlichkeit

p des betreffenden Ausgangs A1

bzw. A 2 dar.

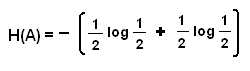

Die

Unbestimmtheit, die dieser Situation zugrunde liegt, wird

in der Kybernetik durch die Größe Entropie

(Symbol H) zum Ausdruck gebracht, wobei

aus inhaltlichen und mathematischen Gründen nicht die

Wahrscheinlichkeit p, sondern der

Logarithmus (Symbol "log") der Wahrscheinlichkeit

p verwendet wird. Dann gilt:

(Das Minuszeichen vor der Klammer erklärt sich daraus,

dass der Logarithmus einer Zahl < 1,0 negativ ist. Der

Wert H(A) ist somit eine Zahl größer, gleich Null).

Wird die Basis 2 für den Logarithmus

gewählt (dyadischer Logarithmus ld),

erhält man für H(A) den Wert H(A) = 1,0.

Dies entspricht der Aussage, dass der Wert der Information

I, die die Unbestimmtheit der skizzierten Situation

aufhebt, den Wert 1,0 bit hat.

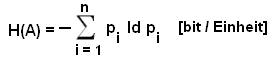

Wenn

eine Situation A mehr als zwei Ausgänge Ai

(mit i = 1, 2, ..., n) hat und diese Ausgänge

unterschiedliche Wahrscheinlichkeiten pi

aufweisen,

dann berechnet sich die Entropie H(A) nach der Formel

Diese Größe entspricht dem Wert der Information

I, die die Unbestimmtheit der

betreffenden Situation aufhebt.

Information kann

somit wie folgt definiert werden: |

|

Information (im Sinne der

kybernetischen Informationstheorie) ist

beseitigte Unbestimmtheit.

Sie ist ihrem Inhalt nach jene reduzierte

Ungewissheit, die ein Empfänger der Information

als Widerspiegelung realer Gegebenheiten erhält.

Wird durch den Erhalt einer Mitteilung die beim

Empfänger ursprünglich gegebene Ungewissheit

jedoch erhöht, handelt es sich um eine

Desinformation.1 |

|

|

1

Gewünscht werden - speziell von den Medien -

sachkundige Informationen, die Ungewissheiten aufheben,

stattdessen erhalten wir oft "Fake News"

(Desinformationen)! |

|